El primer paso para conocer el estado de un proyecto, y saber por por donde debemos empezar a trabajarlo y priorizar tareas, es realizar una auditoria del mismo. Para ello es necesario saber cómo hacer una auditoría SEO. Este estudio será más extenso cuanto más amplia y compleja sea la web a analizar. El resultado será una radiografía de la web, que nos servirá como guía para implementar los primeros cambios en la web, siempre buscando la mejor relación tiempo empleado / rendimiento obtenido. Hay determinadas acciones que se deben realizar de forma prioritaria por su naturaleza. Sin embargo, hay otras cuyo orden se puede decidir. En este caso, lo más apropiado es, como he comentado antes, comenzar por las que tienen efectos más visibles en el corto plazo.

Vamos a comenzar.

1 – Análisis de Rastreo

Lo primero que interesa conocer, es la cantidad de URL’s que de la nuestra web que son rastreables por parte de los buscadores, y las que no. A partir de esta información podremos determinar la optimización que tiene la arquitectura web, el enlazado interno y el estado de las URL’s en función de nuestras necesidades. Este análisis lo podemos dividir en varios apartados a inspeccionar:

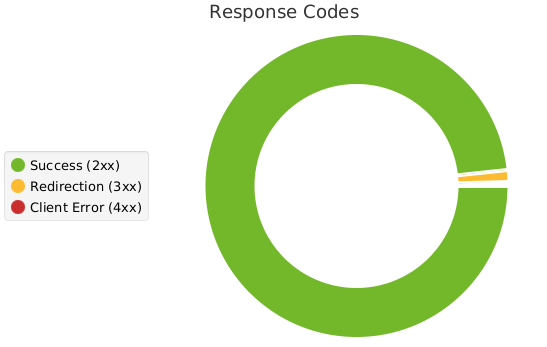

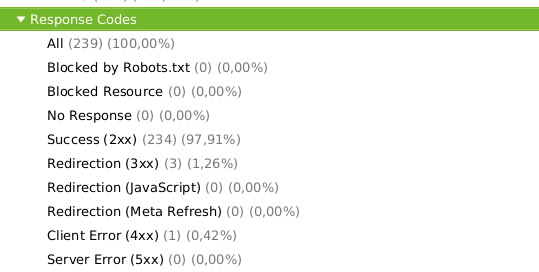

1.1 – Códigos Respuesta del Servidor

Se trata de analizar el estado de las páginas en el momento en que intentan ser accedidas por un usuario, o rastreador.

Una herramienta fundamental para realizar las auditorías (y el SEO en general), es Screamming Frog. Con esta herramienta podremos obtener información de casi cualquier aspectos de la web. También podremos descargar esa información, combinarla, manejarla, etc… según nuestras necesidades. Una maravilla.

Mediante esta herramienta hemos podido ver, como en este caso, la cantidad de URL’s del proyecto, y cuales presentan alguna problema o característica destacada.

Aquí ya tenemos información sobre la que trabajar.

1.2 – Tipos de Archivo que contiene el Proyecto

Es importante conocer los diferentes tipos de archivo que contiene el proyecto, ya que cada tipo de archivo requiere de un trabajo y una optimización diferente. No es el mismo trabajo el que se realiza sobre páginas HTML, que archivos CSS o JS, que la optimización que llevan las imágenes.

1.3 – Configuración del Robots.txt

Esta parte es muy importante de cara al rastreo, ya que es el primer elemento de configuración que se encuentran los rastreadores cuando acceden a nuestra web. Mediante este archivo, vamos a darle a los rastreadores información como:

El tipo de rastreador al que vamos a dar acceso a nuestra web.

Las páginas concretas, o conjuntos de páginas, cuyo rastreo vamos a bloquear.

Esto es muy importante, entre otras cosas, para optimizar el Crawl Budget, o presupuesto de rastreo, que son los recursos (tiempo) que emplea un buscador en rastrear nuestra web. Al indicarle a los rastreadores, mediante el archivo Robots.txt, a que URL’s puede acceder, podremos priorizar aquellas que tenemos más trabajadas, o que tenemos mas interés en posicionar. Así mismo, podremos bloquear aquellas donde no queremos que los rastreadores pierdan su valioso tiempo.

Indicar cual es el archivo del Sitemap. Muy útil para facilitar su lectura por parte de los rastreadores.

La correcta configuración de este archivo es clave, ya que su resultado debe estar alineado con el estado de nuestra web, su arquitectura y enlazado interno, nuestra propuesta de negocio, y el contenido.

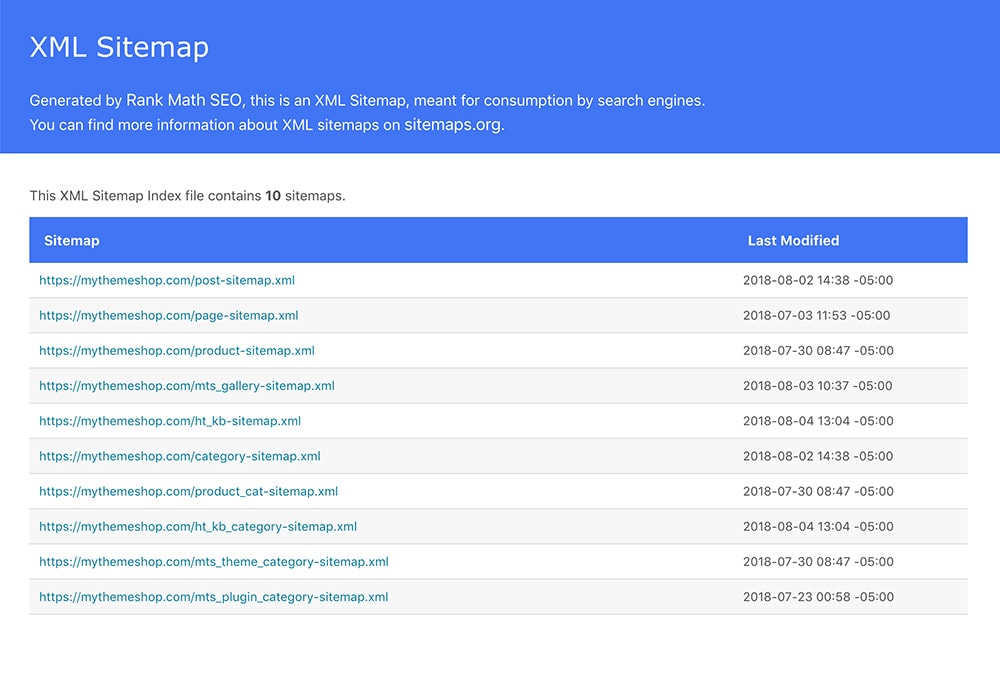

1.4 – URL’s incluidas en el Sitemap.xml

El Sitemap.xml, como su nombre indica, es un mapa de la web que nosotros presentamos tanto a los buscadores como a cualquier usuario que quiera consultarlo.

Este mapa no tiene necesariamente que corresponderse con el mapa real de la web, sino que será una abstracción del mismo, en la que presentaremos la web tal cual queremos queremos que la entiendan y rastreen las arañas.

A diferencia del Robots.txt, este archivo no indica zonas de bloqueo, sino que sirve de ayuda y sugerencia sobre los elementos a rastrear.

En nuestra auditoría, debemos comprobar que la existencia de este archivo, la forma en que se genera, y si las URL’s que contiene coinciden con nuestros objetivos.

Existen numerosas herramientas para crear estos mapas de forma automática, como los plugins para WordPress Yoast SEO y Rank Math. Les damos una pautas, y se genera solo el archivo. No obstante, nunca es bueno dejarlo en automático y despreocuparnos, sino que debemos estar pendientes de que el archivo que se genera es el adecuado.

Con los pasos anteriores, tenemos una idea de las rastreabilidad general del sitio web. Sin embargo, debemos saber también que páginas rastreables están siendo efectivamente rastreadas. Esto se puede realizar a través del análisis de los logs del servidor, que nos indican que URL’s están siendo visitadas, y por quién. Una herramienta muy útil para esto es Screamming Frog Log Analyzer.

Por otro lado, debemos detectar aquellas URL’s huérfanas o que no tenemos controladas totalmente.

2 – Análisis de Indexación

Una vez conocemos el estado del rastreo de la web, debemos saber qué páginas están indexadas por los buscadores, y que indicaciones sobre la indexación de las páginas estamos dando.

En relación a esto, debemos tener en cuenta la lógica del apartado anterior: qué páginas son indexables, y qué páginas están indexadas.

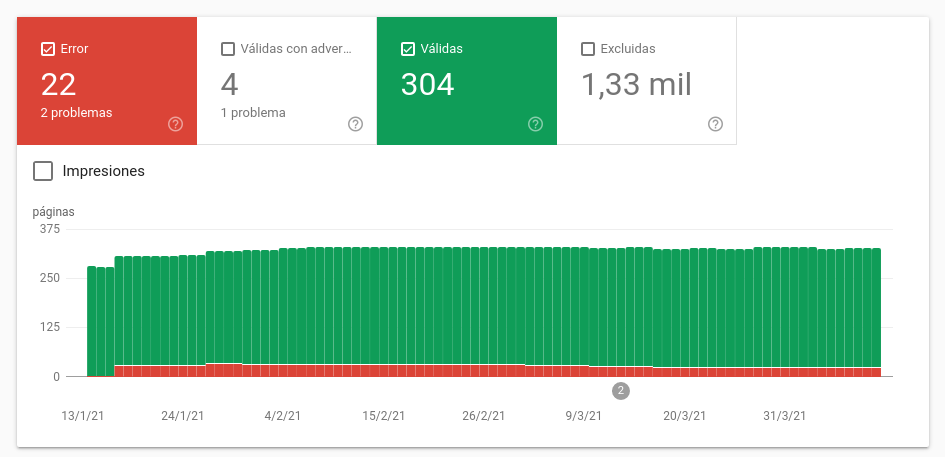

La mejor forma de saber la cantidad de URL’s indexadas por Google, es a través de la herramienta Google Search Console.

En el gráfico anterior se puede ver la cantidad de URL’s indexadas (válidas), las no indexadas (excluidas), y las que contienen errores.

Para definir la indexación de las URL’s de una web, existen 2 tipos de indicaciones que deberemos tener en cuenta y analizar:

2.1 – Directivas de Indexación.

Tienen rango de ley. Existen numerosos tipos, pero los más frecuentes son aquellos que indican si una página debe ser indexada o no (index / no index), y aquellas que indican si los enlaces que contiene una página deben ser seguidos o no (follow / no follow). Deberemos comprobar en la auditoría, si estas directivas de indexación están alineadas con nuestros interesese.

2.2 – Sugerencias de Indexación

No tienen rango de ley, Google puede hacer con ellas lo que considere. La sugerencia más habitual es la que tiene que ver con las etiquetas Canonical. Esta etiqueta viene a decir a los buscadores cuándo una página tiene otra URL de referencia que Google debe tener más en cuenta que la propia página. Se usa habitualmente cuando hay páginas con contenido similar o duplicado.

3 – Análisis de Contenido

En este punto, deberemos realizar un estudio del estado del contenido de nuestra web. Atenderemos, fundamentalmente, a lo siguiente:

Contenido similar

Contenido duplicado

Contenido escaso (thin content)

Presencia de datos estructurados para organizar el contenido

En función del resultado de este este estudio, y de nuestros intereses, podremos implementar las medidas que consideremos oportunas:

Fusión de páginas con contenido similar o duplicado

Colocación de etiquetas canonical des páginas con contenido menos relevante a aquellas mas importantes

Redirecciones

Implentación o revisión de Schema para aquella información que pueda presentarse como datos estructurados

Desarrollo de una estrategia de contenidos para páginas corporativas, blog, categorías, productos…

4 – Análisis de Elementos OnPage

Como complemento al análisis de contenidos, es necesario realizar las comprobaciones necesarias de los elementos destacados de cara al SEO que puede tener una URL. En concreto, es importante revisar:

Los títulos de las URL’s. Meta Etiqueta Title.

Las descripciones. Meta Etiqueta Description.

La correcta jerarquía de los encabezados H1, H2, etc…

La organización de la información en listados.

Los fragmentos de texto destacados, como negritas y cursivas

La correcta configuración SEO de las imágenes, con sus títulos y etiquetas.

Todas estas comprobaciones deberán hacerse para comprobar que el SEO OnPage está correctamente implementado, y además, orientado al posicionamiento según estudios como la investigación de palabras clave, o el estudio del sector y la competencia.

5 – Análisis de Enlazado y Relevancia

Como ya hemos comentado en otros artículos, la importancia (Page Rank) de una web, es un factor fundamental de posicionamiento. También hemos comentado que este Page Rank puede transmitirse de unas URL’s a otras a través de los enlaces. Estos enlaces pueden clasificarse según varios criterios. Uno de ellos es en función de si apuntan a una URL del mismo dominio, o apunta a una URL de otro dominio. Es decir, si se trata de enlaces internos o externos. Esta distinción es muy importante, ya que determinará los aspectos a tener en cuenta, así como las acciones a desarrollar.

5.1 – Enlazado Interno

El análisis del enlazado interno nos llevará a conocer la forma en que se distribuye la importancia por las diferentes partes de la web, y las acciones llevadas a cabo para conseguir esta distribución.

Existe un término que define esta tarea de llevar Page Rank a aquellas zonas que consideramos prioritarias: el Page Rank Sculpting. Existen diferentes formas de realizar esta distribución.

Enlaces NoFollow; deberemos estudiar los enlaces nofollow exitentes en la web, para saber a qué tipo de elementos no se está pasando toda la autoridad posible.

Ofuscación de enlaces; esta técnica convierte, a ojos de Google, cualquier enlace en texto plano. Su existencia también nos da indicaciones sobre las intenciones a la hora de dar importancia a determinadas URL’s de la web.

Profundidad de una URL; deberemos estudiar la profundidad (nº de clicks desde la home) a la que están las páginas de la web. Como sabemos, el Dumping Factor hace que en cada salto entre niveles de profundidad se pierda un porcentaje de Page Rank.

Menús y otro tipo de enlaces; tenemos que estudiar y valorar la existencia de menús generales, de categorías, breadcrumbs (migas de pan), menús en el pié de página, etc… para darnos de cuenta de si la distribución del Page Rank se está haciendo conforme a nuestros intereses.

Por otro lado, deberemos estudiar la arquitectura de la información, para saber si el enlazado interno está cumpliendo realmente su función a la hora de ejecutar de forma eficiente esta arquitectura.

Podemos poner el ejemplo de los Clusters, unidades tématicas de URL’s. Si verificamos la existencia de estos elementos, el enlazado interno deberá de dar respuesta a los mismos, a través de enlaces que relaciones unas URL’s con otras.

5.2 – Enlazado Externo

Analizar bien esta parte es fundamental, ya que el enlazado externo es uno de los pilares del SEO, a ser el elemento que habla sobre nuestras popularidad e importancia.

En la auditoria, deberemos utilizar herramientas para conocer el perfil de enlaces de la web. Este perfil de enlaces estará constituido por todos los enlaces que apuntan a las diferentes URL’s de la web. En concreto, para conocer este perfil de enlaces, habrá que atender a datos como:

Cantidad de enlaces entrantes

Página origen del enlace.

TCalidad de la página de origen.

Textos incluidos en los anchor text (texto ancla del enlace).

Page Rank de la página de origen.

Relación entre los enlaces follow / nofollow.

Velocidad en la consecución de enlaces.

El perfil de enlaces ideal debe tener como referencia al de empresas mejor posicionadas de nuestro sector. En este sentido, deberemos analizar nuestros enlaces entrantes e ir proyectando el tipo de estrategias a desarrollar para homologarlo con el de las páginas webs más potentes. Tras esto, se tratará de ir ampliando y mejorando lo ya existente.

Un perfil de enlaces con muchos enlaces de baja calidad, spam, o similares, puede comprometer nuestro posicionamiento en el futuro. Es posible incluso, si se considera oportuno, hacer una limpieza de enlaces malos, que se puede hacer basicamente por 2 vías:

Solicitando a la web de origen la retirada del enlace.

Notificando a Google, a través de un disavow en Google Search Console, aquellos enlace que nos apuntan y que no queremos que se tengan en cuenta.

6 – Análisis de WPO

Cada vez más, el WPO (Web Page Optimzatiom), o comportamiento de la página web, está siendo un factor relevante de cara al posicionamiento web. Para poder optimizar este rendimientos, representado fundamentalmente por la velocidad de carga de la web, debemos atender a aspectos como:

Rendimiento del servidor elegido, así como su configuración

CMS utilizado, plantilla, plugins, etc…

Limpieza y optimización de la BBDD

Código limpio y optimizado. En este punto, cabe destacar al trato que se haga de los elementos HTML, CSS y JS. En ocasiones, y en función del CMS o plantilla, suelen ser muy pesados y mal configurados, lo que ralentiza mucho la web. Será necesario analizar y optimizar el uso de estos códigos.

Tratamiento de los elementos multimedia

La revisión de todos elementos será clave para conseguir una buena velocidad de carga, y un buen rendimiento de la web. No obstante, es importante chequear el estado de los Core Web Vitals, que son indicadores clave para la velocidad de carga de la web, y que abordaremos más profundamente en otro artículo.

7 – Análisis del Entorno

Para realizar una buena auditoria, es muy importante poner en contexto el proyecto en que estamos. No hay 2 proyectos iguales ni 2 auditorias iguales, y esto se debe, en parte, a los diferentes sectores y contextos en los que se dan. No será lo mismo auditar y desarrollar una estrategia SEO sobre un gran ecommerce en un entorno de gran competencia, que una web corporativa o nicho de negocio poco saturado.

7.1 – Estudio del Sector

Será necesario auditar el sector en el que la web intenta posicionarse, con la idea de saber qué tipo de partida se está jugando. El sector va a determinar muchas de las características de la web, y estas características van a ser claves a la hora de trabajar el SEO. Tipo de contenido, menús, formas de conseguir enlaces, configuración técnica, etc… van a ser determinantes. No solo se trata hacer las cosas bien en lo que se refiere al posicionamiento SEO de una forma general. Se trata de adaptarlo a cada contexto de la forma más adecuada y eficiente posible.

7.2 – Estudio de la Competencia

Los sectores mas competidos requerirán de mayores esfuerzos e inversión para lograr objetivos SEO. Esto es una cuestión clave en una auditoria. Debemos ser conscientes que el posicionamiento es algo dinámico, influido por lo que hagan una gran cantidad de actores en cada momento.

Si mis compañeros de SERP’s van fuerte, yo deberé ir fuerte. De nada sirve una estrategia de Linkbuilding o de Contenidos si no tenemos esto en cuenta. Además de tener una idea de los esfuerzos que necesitamos, conocer a nuestra competencia nos servirá para:

Conocer estrategias de contenido que están funcionando

Ver en qué lugares colocan enlaces, para valorar cuales podemos replicar

Saber que tipo de resultados para la SERP’s están apareciendo para búsquedas centrales que nos interesan: enlace, imagen, local, fragmento destacado…

Tipos de arquitectura utilizada, zonas destacadas, y tratamiento de la información de aquellas webs mejor posicionadas.

Y así, hasta completar casi cualquier aspecto que consideremos relevante estudiar de nuestra competencia. He dejado este punto para el final, al no tratarse de una parte «propia» de la auditoria de la web, pero quizá su lugar esté al principio, ya que todos los análisis y actuaciones derivadas de la auditoria se van a ver atravesadas por el entorno en que desarrolle el proyecto web.