Sabemos que en el SEO existen diferentes áreas o disciplinas a tener en cuenta. Una de ellas es el SEO Técnico. Podríamos entenderlo como la puesta a punto necesaria de la web antes de realizar acciones de crecimiento del tráfico. Es el complemento necesario al SEO de Contenidos y al LinkBuilding. A continuación vamos a desgranar todos los puntos de este tipo de técnicas y cómo trabajar el SEO Técnico.

1 – El SEO Técnico como Punto de Partida

Todas las áreas del SEO son necesarias para posicionar una web, pero podemos decir que existe cierta jerarquía entre ellas. Quizá esta jerarquía no responda a una cuestión de importancia, pero si responde a qué tareas es necesario haber realizado antes de abordar otras.

En este sentido, podemos afirmar que antes de trabajar el SEO más expansivo, debemos tener la maquinaria afinada para que todos los esfuerzos y recursos que se inviertan, por ejemplo, en contenidos y LinkBuilding se maximicen y devuelvan los mejores resultados.

Pues esta puesta punto la podemos llamar SEO Técnico. Digamos que todas las acciones de esta rama del SEO están orientadas a dos objetivos concretos:

Facilitar el rastreo e indexación de la web por parte de los motores de búsqueda.

Generar la mejor experiencia de usuario posible.

Para lograr estos objetivos, es importante atender a los siguientes puntos:

2 – Servidor

El servidor es el encargado de servir las páginas tanto a los usuarios como a los bots. Un mal funcionamiento de este, puede dificultar el acceso a las URL’s, comprometiendo el posicionamiento, hasta el punto de poder llegar a desindexarse las páginas.

En este punto, recordar que todos los errores 5XX tienen que ver con el servidor. Pero no solo los errores pueden afectar al posicionamiento. Un tiempo de espera elevado, o los problemas para renderizar las páginas (sobre todo JavaScript), pueden hacer que los rastreadores accedan a versiones parcialmente cargadas.

Para que el servidor esté optimizado y ofrezca mejores posibilidades para el posicionamiento, es necesario que sus características sean las apropiadas. En este sentido, es necesario atender a cuestiones como:

El tipo de disco que usa. En este sentido hay 2 opciones: HHD y SSD. Para el SEO, se recomiendan los discos SSD, aunque su coste sea más elevado.

La capacidad de disco. Es bueno disponer de capacidad de almacenamiento suficiente, ya que a mayor ocupación del disco, mayor lentitud en el acceso y recuperación de los datos.

La memoria RAM. Fundamental contar con suficiente memoria para servir las páginas de nuestro sitio.

Capacidad de tráfico. Es importante asegurarnos que no nos afecta cualquier limitación de tráfico, por lo que debemos tener contratada suficiente capacidad.

Esta web está alojada en los servidores de Webempresa.

3 – Certificados del Dominio

Tener un certificado seguro en el dominio es muy importante tanto desde el punto de vista del usuario, como la hora de ser calificado por los buscadores.

La mayoría de los servidores proporcionan estos servidores de forma gratuita.

Es posible que tras las instalación del certificado, el navegador nos indique que sigue habiendo elementos no seguros. Esto sucede porque pueden quedar en el código llamadas a elementos bajo el protocolo http. Para solucionar esto, en Worpdress existe el plugin Really Simple SSL.

4 – Código Fuente

Muy importante a la hora de trabajar el SEO Técnico, es la limpieza y optimización del código fuente de la web. Para ello, podemos tener en cuenta lo siguiente:

CMS y plantilla utilizadas. Es importante asegurarnos que los elementos que elegimos están optimizados.

Minificar los los archivos HTML, CSS y JS. Para esto, existen numeros plugin en Wordpres, como Rank Math y Autoptimize.

5 – Bases de Datos

Otro elemento importante que debemos mantener optimizado son las Bases de Datos de nuestra web. Es muy habitual que estos registros acaben teniendo cantidad de información que ya no necesitamos, y que otro tipo de información no se encuentre almacenada de la manera más eficiente.

Por ello es necesario tener esto controlado, y que las consultas y modificaciones en las Bases de Datos, se hagan de la forma más óptima posible.

Para esta tarea, también contamos en WordPress con plugins que nos pueden ayudar, como WP-Sweep, que realiza tareas como limpiar revisiones, comentarios sin aprobar, metas de páginas o entradas huérfanas, optimiza las tablas, etc… Sin duda muy útil.

6 – Optimización del Rastreo

A la hora de optimizar el SEO Técnico de una web, es importante tener configurar y optimizar la forma en que los motores de búsqueda pueden rastrear nuestra web. Para ello es muy importante fijarnos en los siguiente aspectos:

6.1 – Códigos Respuesta del Servidor

En primer lugar, debemos conocer las respuestas que reciben los rastreadores por parte de los servidores cuando intentan acceder a los recursos para rastrear la web. El análisis de estos código respuesta será importante porque la capacidad de acceso a los servidores es fundamental para el SEO. Los tipos de códigos respuesta que nos podemos encontrar, son los siguientes:

Códigos 2XX: Petición resuelta con éxito

Códigos 3XX: Redirecciónes

Códigos 4XX: Recurso no Accesible por no existir o estar prohibido

Códigos 5XX: Fallo del servidor

Para analizar estos códigos respuesta, una buena opción es usar un crawler como Screamming Frog. En función de los códigos de respuesta obtenidos, deberemos trabajar para resolver los posibles problemas que existan.

6.2 – Tipos de Archivos

Otro aspecto importante a la hora analizar el rastreo, es saber el tipo de archivos que se encontrará el rastreador en su paso por la web. En este punto, prestaremos especial atención a los tipos de archivos más habituales a los que acceden estos rastreadores: HTML, CSS, JS e Imágenes.

En lo que se refiere al tratamiento de estos archivos, debemos asegurarnos de lo siguiente:

Su acceso está habilitado (recomendable en la mayoría de los casos).

En el caso de HTML, CSS y JS, deben estar minificados u optimizados de alguna forma.

En el caso de las imágenes, deben estar bien etiquetadas y optimizadas en cuanto a peso y tamaño.

6.2 – Optimización de Nuestro Crawl Budget

Este concepto es clave a la hora de trabajar el rastreo es el Crawl Budget, o Presupuesto de Rastreo. Responde a la cantidad de recursos (tiempo) que emplea el buscador en rastrear nuestra web. Este tiempo es variable y suele cambiar en función de la antigüedad o autoridad del dominio, o del tipo de web cómo esté trabajada.

Asumiendo esta limitación en la asignación de recursos, es necesario indicar a los rastreadores que URL’s o zonas de la web son prioritarias para el rastreo, ya que queremos indexarlas y posicionarlas antes.

Estas indicaciones las daremos a partir de los siguientes archivos: sitemap.xml y robots.txt

6.3 – Sitemap.xml

Como su propia nombre indica, se trata de crear un archivo que contendrá un mapa con la estructura de nuestra web, y en el que incluiremos preferentemente aquellas URL’s que consideremos relevantes, y cuya indexación y posicionamientos sean prioritarias.

Aunque existen plugins para WordPress que generan este tipo de archivos de forma automática a partir de las configuraciones que le indiquemos (como Rank Math y Yoast SEO), es muy importante realizar seguimientos manuales para asegurarnos de que estos archivos contienen la información exacta que queremos.

6.4 – Robots.txt

Si con el archivo Sitemap.xml ayudamos a los buscadores a rastrear nuestra web, con el archivo Robots.txt, indicaremos lo siguiente:

Que rastreadores (User-Agent) pueden acceder a la, y cuales no.

A que URL’s, o conjunto de las mismas, están permitido el acceso (Allow), y a cuales no (Disallow). Para indicar esto se pueden indicar las URL’s específicas, o se pueden usar expresiones regulares.

Ruta de Sitemap.xml. Debido a que este archivo es el primero que buscan los rastreadores, es aconsejable indicarle donde debe ir para encontrar el mapa del sitio.

La configuración y todo lo que puede incluirse en este archivo, así como su alcance, dan para un estudio a fondo mucho más amplio. Con las indicaciones anteriores ya podemos tener una idea del potencial y la importancia para el SEO del Robots.txt.

6.5 – Breadcrumbs

Los menús de breadcrumbs, o migas de pan, son elementos que indican, mediante enlaces, la ruta de la URL en la que nos encontramos. Son elementos importantes, desde los siguientes puntos de vista:

Experiencia de Usuario.

Distribución del Page Rank.

Facilidad a los buscadores para el Rastreo.

6.6 – Paginación

La paginación es algo muy habitual en las páginas web. Se usa tanto para entradas de blog, como para productos, como para cualquier tipo de contenido que contiene muchos elementos.

Para que los motores de búsqueda puedan rastrear las URL’s que forman parte de una cadena de paginación, es necesario indicarlo correctamente y colocar las etiquetas adecuadas (rel=»next» href…. y rel=»prev» href…)

De esta manera, indicaremos a los rastreadores que se encuentran ante una página paginación, y cual es la siguiente URL que deben visitar.

6.7 – Arquitectura Web

A la hora de facilitar el rastreo de una web, es muy importante que esta tenga una estructura que facilite el paso de los rastreadores entre las diferentes URL’s y las diferentes secciones de la web. Para ellos necesitamos una estructura limpia, optimizada, y bien enlazada.

6.8 – Páginas Huérfanas

Para un buen rastreo de toda la web por parte de los motores de búsqueda, es muy importante que no haya ninguna URL que no esté al menos conectada con al menos una página más. En función de la importancia de la URL, deberán existir más enlaces hacia esa página.

6.9 – Profundidad de Página

Hay un aspecto relevante a la hora de organizar la arquitectura y el rastre de una página web, y es la profundidad a la que se encuentra una determinada URL. Esta profundidad representa el número de clicks que son necesarios para llegar a esta URL desde la home. Además de dificultar el acceso a la URL, el hecho de que una determinada web a esté a cierto nivel de profundidad, hace que le afecte de menor o mayor manera el llamado Dumping Factor.

El Dumping Factor es una corrección que se realiza sobre el Page Rank de una URL en función de su nivel de profundidad. Se estima que por cada nivel que nos alejamos de la home, se pierde un 15% de este Page Rank.

6.10 – Registro de Logs

Es importante realizar un seguimiento de lo que sucede cuando los rastreadores visitan nuestra web y navegan a través de ella. Para ello es muy útil y análisis de los logs del servidor. El registro que deja, por ejemplo Google, en nuestro servidor cuando lo visita, lo podemos estudiar con herramientas como Screamming Frog Log Analyzer, y de esta forma sabremos si las configuraciones que hacemos son efectivas a la hora de indicar nuestras preferencias de rastreo.

7 – Optimización de la Indexación

A la hora de indicar a los motores de búsqueda que preferencias tenemos sobre la forma en que queremos que se indexen las páginas, tenemos varias opciones.

7.1 – Acceso de los bots a las páginas

Para que se pueda realizar la indexación por parte de los motores de búsqueda, es necesario que previamente hayamos permitido el acceso a los mismos a nuestras URL’s. Como hemos indicado en secciones anteriores, esto lo realizaremos configurando correctamente el archivo Robots.txt, y sus directivas Allow y Disallow.

7.2 – Directivas de Indexación

Existen 2 tipos de indicaciones que le podemos dar a los rastreadores para decirles cómo queremos que trate una página determinada y sus elementos: directivas y sugerencias. Como su propio nombre indica, las primeras son de obligado de cumplimiento por los buscadores, mientras que las segundas son sugerencias para que el buscador las tenga en cuenta.

Pues bien, centrándonos en las directivas de indexación, existen lo que se denomina las etiquetas meta-robots. Estas etiquetas tiene 2 parámetros fundamentales, cada uno de los cuales puede tomar 2 valores. indicamos

Parámetro de indexación: se encarga de decir a los rastreadores si esa página debe ser indexada o no. Sus posible valores son Index / No Index.

Parámetro de Seguimiento de Enlaces: se encarga de decir a los rastreadores si deben seguir y rastrear los enlaces que se encuentren dentro de esa página. Sus posibles valore son Follow / No Follow.

7.3 – Sugerencias de Indexación

Como ya hemos comentado, existen otros tipo de indicaciones que dan información a los rastreadores sobre cómo deben interpretar algunos aspectos de la web, siendo ellos en última instancia los que decidan como utilizar la información incluida en la directiva.

Estas sugerencias de indexación son las siguientes:

Canonical: es una etiqueta que indica, dentro de una URL, cual es la URL principal relacionada con el contenido o los elementos que dicha URL contiene. Se explica mejor con un ejemplo: si tenemos 2 URL’s, por ejemplo de fichas de producto, que tienen contenido muy similar, mediante la etiqueta <link rel=“canonical” href=“https://www.paginabuena.com/” /> indicamos que toda la consideración debe recaer sobre esta URL, que es la canónica.

Paginaciones: como hemos indicado en secciones anteriores, es necesario, en el caso de las paginaciones, indicar a los rastreadores cual son las URL anterior y posterior de la serie paginada. Esto se realiza con las etiquetas next y prev.

7.4 – Contenido Duplicado

Para facilitar el entendimiento de nuestra web por parte de los motores de búsqueda, y por tanto la indexación de los contenidos, es muy importante que esta no contenga contenido duplicado. Además, esto podría desembocar en canibalizaciones de palabras clave.

Es importante considerar las opciones de fusionar las páginas con contenido similar, o bien hacer uso de las directivas y sugerencias de indexación para optimizar este proceso.

7.5 – Auditar Redirecciones

Las redirecciones consumen mucho recursos, además de que pueden dar muchos problemas. Esto sucede cuando se producen redirecciones infinitas, o bien cadenas de redirección muy largas. Estos casos pueden generar problemas en la indexación, aparte de consumir muchos recursos, lo que puede significar un mal uso del Crawl Budget.

8 – WPO y Renderizado

La optimización del rendimiento de la web es un factor cada vez más importante a la hora de posicionar una web. En este sentido, son varios los aspectos a tener en cuenta para lograr el mejor funcionamiento de la web. Algunos de estos aspectos que influyen en el WPO los hemos tratado al principio de este artículo, como son la elección del servidor sus características, o la optimización del código y las bases de datos.

8.1 – Tiempo de Carga

El tiempo de carga es fundamental para obtener un buen posicionamiento SEO. En primer lugar, porque está muy relacionado con la experiencia de usuario, que es un aspecto que tienen muy en cuenta los buscadores.

Además, por parte de los rastreadores, la optimización del tiempo de carga les facilita el trabajo. Un buen tiempo de carga implica que se consuma menos Crawl Budget en la primera carga de la web, y además garantiza que el rastreador no comienza a examinar una web parcialmente cargada.

8.2 – Tamaño de Página

El tamaño de la página que los servidores tienen que cargar también es un factor importante que afecta al WPO. A mayor tamaño, mayor lentitud y dificultad a la hora de procesar la URL. Es por esto que debemos intentar reducir al máximo el tamaño de las páginas de nuestra web.

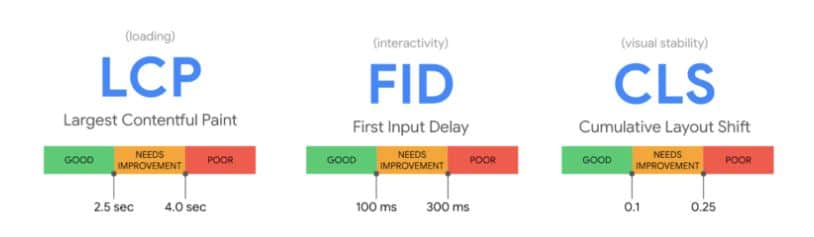

8.2 – Core Web Vitals

Dentro del conjunto de factores relacionados con el WPO, existen un grupo que está teniendo una importancia cada vez mayor, y que se denomina Core Web Vitals. Las factores de este grupo están relacionados con el tiempo que tarda un usuario en poder comenzar a interactuar con la URL solicitada.

Estos factores son los siguientes:

LCP: Largest Content Panitful. Indica el tiempo que tarda en cargarse en elemento más grande de la ventana gráfica. Esta métrica pretende reflejar la percepción de velocidad que tiene un usuario al cargar una web.

FID: First Input Display. Esta métrica mide el tiempo que tarda una web en ofrecer alguna posibilidad de interacción con el usuario. A menor FID, mejor experiencia.

CLS: Cumulative Layout Shift. Se encarga de medir el tiempo de carga acumulado de todos los cambios de diseño. Digamos que mide lo que tarda el proceso de carga de una web en volverse estable.

A continuación podemos ver una imagen con los valores ideales para los Core Web Vital:

9 – Elementos de Rankeo

Una vez que nuestra web es rastreable e indexable, es necesario que los buscadores la consideren apropiada y con interés para ser indexada. Esto se puede conseguir mandando señales de relevancia a las URL’s. Para mandar estas señales, tenemos algunas opciones como las siguientes:

9.1 – Enlaces Internos y Externos

Los enlaces son la base de internet, y las señales que se mandan a través de los mismos son muy tenidos en cuenta por parte de los rastreadores. Si establecemos un enlazado interno que dote a la web de una buena arquitectura y que ayude a destacar las URL’s o zonas mas destacadas, estaremos ayudando a su indexación por parte de los buscadores.

Por otro lado, si mandamos señales de autoridad a través de enlaces externos, también estaremos indicando a los buscadores la importancia de una determinada URL, aumentando así sus posibilidades de indexación. Para que los enlaces externos tengan el efecto deseado en lo que se refiere a la indexación de la URL, es muy importante que estos enlaces sean de una determinada calidad, y estén colocados en webs o URL de una determinada autoridad. Lo contrario puede no facilitar la indexación, o incluso llegar a comprometarla, si los buscadores consideran los enlaces como spam.

9.2 – Grupos de Contenido

Otra forma de conseguir la indexación de nuestras URL’s, es que estas estén agrupadas en grupos de páginas con una relación semántica determinada. Son los denominados Clusters. Estos clusters, al contener URL’s relacionadas, y que además se enlazan entre sí, harán que estas ganen autoridad como elementos que tratan un tema determinado.

Como ejemplos de clusters, podemos poner las categorías de un blog o tienda online, o las verticales de una web de monetización.

10 – Clicabilidad

Para conseguir visibilidad y por tanto clicabilidad, es muy importante que nuestras URL’s aparezcan en lugares destacados de las páginas de búsqueda. Esto significa aparecer en las primeras posiciones de las páginas de resultados de Google, la SERP. Pero no solo. Hoy día, las SERP’s contienen resultados en diferentes formatos para satisfacer la intención de búsqueda de los usuarios.

Por ello, debemos adaptar el formato de nuestro contenido para ser susceptibles de aparecer según la intención de búsqueda del usuario (imágenes, resultados locales, productos, reserva de hoteles…)

Por otro lado, debemos tener en cuenta, a la hora de crear nuestro contenido, que existe la posibilidad de alcanzar la posición 0, o «featured snippet».

Para todo esto, es muy importante el formato que le demos a nuestro contenido.

10.1 – Datos Estructurados

Una manera de dar formato a nuestro contenido es a través de los datos estructurados o Rich Snippets. Mediante código, indicamos a los buscadores el tipo de contenido ante el que se encuentra cuando llega a una determinada URL. De esta manera, podrá entender mejor el contenido, y presentarlo en las SEPS de forma estructurada y que facilite su entendimiento por parte de un usuario que tiene una intención de búsqueda determinada.

10.2 – Fragmentos Destacados

Como hemos comentado anteriormente, es importante diseñar el contenido que ofrecemos teniendo en cuenta la posición 0 de la SERP. Para ello, ante una búsqueda determinada del usuario, probablemente con intención informacional, debemos preparar el contenido para que este pueda ser mostrado en esta posición 0, sabiendo el formato de respuesta corta o listado que generalmente tienen los elementos en esta posición.

Señalar que para ser candidato a aparece en estar posición 0, es necesario estar previamente entre los primeros resultados de la SERP para esa búsqueda.

< /a>

< /a>